Go (Golang) Nasıl Çalışır? - Derinlemesine Runtime Analizi

Go (Golang) Nasıl Çalışır?

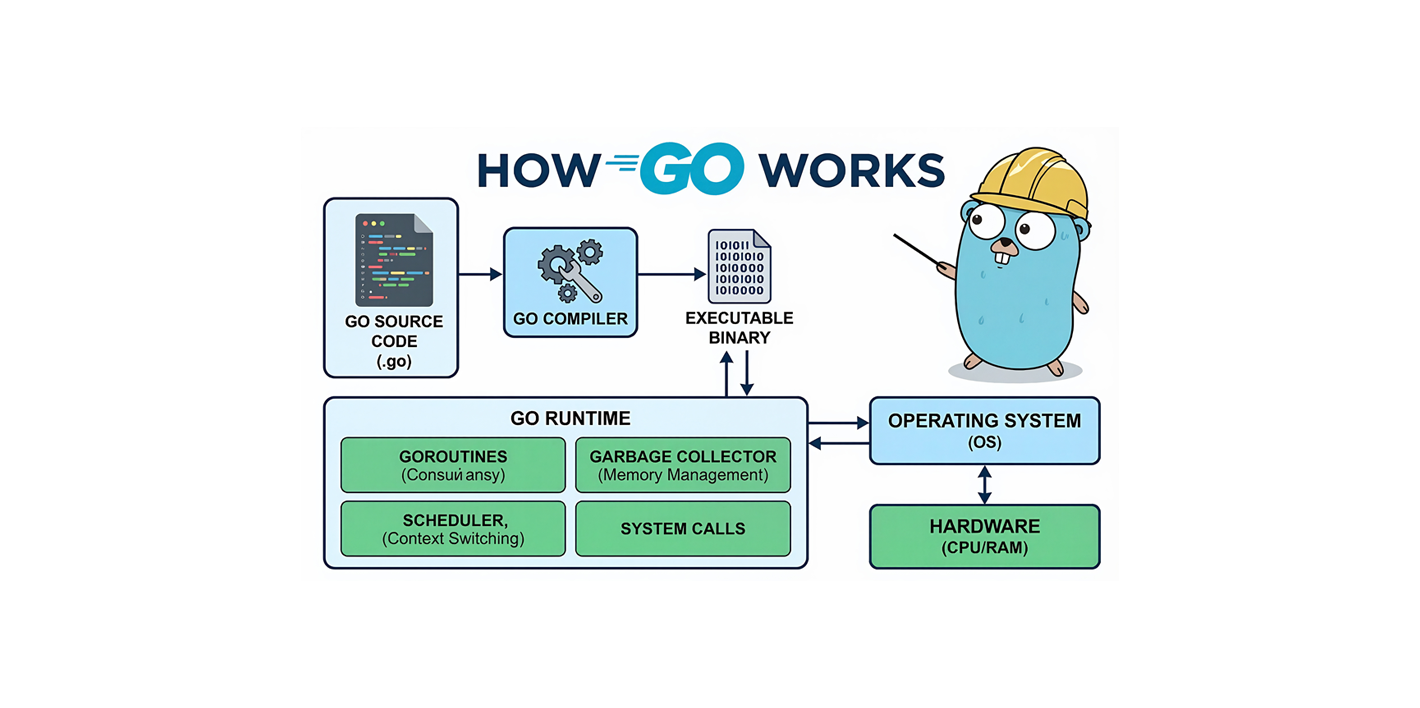

Go (Golang), Google tarafından geliştirilen, modern yazılım geliştirme ihtiyaçlarını karşılamak için tasarlanmış bir programlama dilidir. Bu makalede, Go’nun derleme sürecinden runtime mekanizmalarına, goroutine’lerden garbage collection’a kadar tüm çalışma modelini detaylı bir şekilde inceleyeceğiz.

Özet

- Derleme Süreci: Lexer, Parser, Type Checker, SSA, Code Generation

- Runtime Mekanizmaları: Scheduler (M:P:G), Memory Manager, Garbage Collector

- Concurrency Model: Goroutine’ler, Channel’lar, Select statement

- Performance: Native binary, düşük latency, yüksek throughput

- Production Ready: Case studies, debugging senaryoları, optimization techniques

Not: Bu makale, Go runtime’ın derinlemesine bir incelemesidir. Production uygulamalarında bu bilgileri kullanırken, Go’nun resmi dokümantasyonunu ve best practice’leri de göz önünde bulundurmanız önerilir.

1. Go Programının Yaşam Döngüsü

Bir Go programı yazıp çalıştırdığınızda şu adımlardan geçer:

Adım Adım Açıklama

- Kaynak Kod (.go): Go kaynak dosyaları yazılır

- Derleme (Compile):

go buildveyago runkomutu ile derleme yapılır - Çalıştırılabilir Dosya (Binary): İşletim sistemine özel binary oluşturulur

- Go Runtime Başlatılması: Runtime bileşenleri initialize edilir

- main() Fonksiyonunun Çalışması: Program başlar

Go, yorumlanan bir dil değildir. Kodunuz önceden derlenir (ahead-of-time compilation) ve işletim sisteminde doğrudan çalıştırılır. Bu sayede:

- Hızlı başlangıç: JIT derleme gecikmesi yok

- Öngörülebilir performans: Runtime derleme overhead’i yok

- Küçük binary boyutu: Runtime dahil olsa da optimize edilmiş

2. Derleme (Compile) Süreci

Go derleyicisi, modern bir derleme pipeline’ı kullanır:

Derleme Aşamaları

2.1 Lexer & Tokenizer

Kaynak kodu token’lara ayırır:

- Anahtar kelimeler (

func,var,if) - Operatörler (

+,-,:=) - Literaller (string, number)

- Tanımlayıcılar (değişken, fonksiyon isimleri)

2.2 Parser (AST Generation)

Token’ları Abstract Syntax Tree (AST) yapısına dönüştürür:

|

|

Bu kod şu AST yapısını oluşturur:

- Function declaration node

- Parameter list nodes

- Return statement node

- Binary expression node

2.3 Type Checker

Statik tip kontrolü yapar:

- Tip uyumsuzluklarını tespit eder

- Interface implementasyonlarını kontrol eder

- Tip çıkarımı (type inference) yapar

2.4 Escape Analysis

Değişkenlerin stack’te mi yoksa heap’te mi saklanacağına karar verir:

|

|

2.5 SSA (Static Single Assignment)

Kod, SSA formuna dönüştürülür. Bu, optimizasyonlar için kritiktir:

SSA Form Özellikleri:

- Her değişken sadece bir kez assign edilir

- Data flow analizi kolaylaşır

- Optimizasyonlar daha etkili olur

2.6 SSA Optimization Passes

SSA formunda birçok optimization pass çalıştırılır:

1. Dead Code Elimination

Kullanılmayan kod’u kaldırır:

|

|

Nasıl Çalışır:

- Data flow analizi ile kullanılmayan değişkenleri tespit eder

- Unreachable code’u kaldırır

- Unused function’ları kaldırır

2. Constant Propagation

Sabit değerleri yayar:

|

|

Nasıl Çalışır:

- Constant expression’ları compile-time’da hesaplar

- Constant değerleri kullanım yerlerine yayar

- Conditional branch’leri optimize eder

3. Common Subexpression Elimination (CSE)

Aynı ifadeyi tekrar hesaplamayı önler:

|

|

Nasıl Çalışır:

- Expression’ları hash table’da saklar

- Aynı expression’ı tekrar bulursa reuse eder

- Register pressure’ı azaltır

4. Loop Invariant Code Motion

Loop dışına taşınabilen kod’u taşır:

|

|

Nasıl Çalışır:

- Loop invariant analizi yapar

- Loop içinde değişmeyen expression’ları tespit eder

- Bunları loop dışına taşır

5. Inlining Decisions

Küçük fonksiyonları inline eder:

|

|

Inlining Kriterleri:

- Fonksiyon boyutu (genellikle < 40 satır)

- Call frequency

- Function complexity

- Recursive değil

Inlining Avantajları:

- Function call overhead’i yok

- Daha fazla optimization fırsatı

- Better register allocation

Inlining Dezavantajları:

- Binary size artabilir

- Instruction cache pressure

2.7 Code Generation

SSA’dan makine koduna dönüşüm:

- Register allocation

- Instruction selection

- Peephole optimizations

Register Allocation:

- Live variable analysis

- Register spilling (gerekirse)

- Register coalescing

Instruction Selection:

- Platform-specific instruction’ları seçer

- Instruction scheduling

- Pipeline optimization

Derleme Sonucu

Derleme sonunda platforma özel binary oluşur:

| Platform | Binary Format | Örnek |

|---|---|---|

| Linux | ELF (Executable and Linkable Format) | ./myapp |

| Windows | PE (Portable Executable) | myapp.exe |

| macOS | Mach-O | ./myapp |

Not: Go binary’leri çoğu zaman runtime’ı da içinde barındırır. Bu yüzden deployment oldukça kolaydır - sadece binary’yi kopyalayıp çalıştırabilirsiniz.

Cross-Compilation

Go, cross-compilation’ı native olarak destekler:

|

|

3. Go Runtime Nedir?

Go Runtime, program çalışırken arka planda aktif olan bir sistemdir. JavaScript’teki V8 Engine ne ise, Go için Go Runtime odur.

Runtime Bileşenleri

3.1 Goroutine Scheduler

- Goroutine’leri OS thread’lerine dağıtır

- Work-stealing algoritması kullanır

- M:P:G modeli ile çalışır

3.2 Memory Manager

- Stack ve heap yönetimi

- Memory pool’ları

- Allocation optimizasyonları

3.3 Garbage Collector

- Concurrent mark-and-sweep

- Low-latency tasarım

- Automatic memory reclamation

3.4 Channel Implementation

- Channel’ların runtime implementasyonu

- Select statement mekanizması

- Blocking/unblocking logic

3.5 System Calls

- OS ile iletişim

- Network I/O

- File I/O

Runtime Başlatılması

Program başladığında runtime şu sırayla initialize edilir. Bu süreç runtime.main() fonksiyonundan önce gerçekleşir:

Bootstrap Sequence Detayları

1. Entry Point (_rt0_amd64)

|

|

2. TLS (Thread Local Storage) Initialization

TLS, her OS thread’in kendi goroutine (g), machine (m) ve processor (p) pointer’larına hızlı erişim sağlar. Bu, scheduler’ın performansı için kritiktir.

3. Runtime Args Parsing

GOGCdeğişkenini okurGOMAXPROCSdeğerini belirlerGODEBUGflag’lerini parse eder- Memory limit’leri ayarlar

4. CPU Detection

|

|

5. Memory Allocator Initialization

mcache,mcentral,mheapyapıları oluşturulur- Size class’lar initialize edilir

- Memory pool’lar hazırlanır

6. Scheduler Initialization

|

|

7. Signal Handling Setup

Go, signal’ları şu amaçlarla kullanır:

- SIGURG: Async preemption (Go 1.14+)

- SIGQUIT: Stack trace dump (Ctrl+)

- SIGSEGV: Segmentation fault handling

- SIGINT/SIGTERM: Graceful shutdown

8. Network Poller Initialization

|

|

Network poller, I/O işlemlerini non-blocking yapmak için kullanılır.

9. Defer Mechanism Defer stack’i ve panic/recover mekanizması hazırlanır.

10. runtime.main() Çağrısı

|

|

Runtime Başlatma Zaman Çizelgesi

Toplam bootstrap süresi genellikle 1-2 milisaniye civarındadır.

4. Goroutine Nedir?

Goroutine, Go’nun concurrency modelinin temelidir. OS thread’lerinden çok daha hafif ve verimli bir eşzamanlılık birimidir.

Goroutine Oluşturma

|

|

Goroutine vs Thread Karşılaştırması

| Özellik | OS Thread | Goroutine |

|---|---|---|

| Başlangıç Stack | ~2 MB | ~2 KB |

| Başlatma Süresi | ~1-2 ms | ~1-2 µs |

| Maksimum Sayı | Binlerce | Milyonlarca |

| Scheduler | OS Kernel | Go Runtime |

| Context Switch | Pahalı (kernel mode) | Ucuz (user mode) |

Goroutine Yaşam Döngüsü

Goroutine Özellikleri

- Hafiflik: 2KB başlangıç stack boyutu

- Hızlı Başlatma: Mikrosaniyeler içinde başlatılabilir

- Dinamik Stack: İhtiyaç duydukça büyür (max 1GB)

- Cooperative Scheduling: Goroutine’ler gönüllü olarak CPU’yu bırakır

- Work Stealing: Boşta kalan P’ler başka P’lerden iş çalar

Pratik Örnek

|

|

Bu örnekte 10,000 goroutine başlatılabilir. Aynı sayıda OS thread başlatmaya çalışsaydınız, sistem kaynaklarınız tükenirdi.

5. Go Scheduler Nasıl Çalışır?

Go scheduler, goroutine’leri OS thread’lerine dağıtan akıllı bir sistemdir. M:P:G modeli kullanır.

M:P:G Modeli

Model Bileşenleri

G (Goroutine)

- Çalışacak iş birimi

- Kendi stack’ine sahip

- Program counter (PC) içerir

- Channel, mutex gibi wait objeleri içerir

P (Processor)

- Çalışma kapasitesi (context)

- Her P, bir local goroutine queue’suna sahip

- Sayısı genellikle CPU çekirdek sayısına eşittir (GOMAXPROCS)

- Work-stealing için global queue’ya erişimi vardır

M (Machine)

- OS thread’i temsil eder

- P ile ilişkilendirilir

- Gerçek CPU’da çalışır

- System call yaparken P’den ayrılabilir

Scheduler Algoritması

Scheduler Özellikleri

- Work Stealing: Boşta kalan P’ler, dolu P’lerin queue’larından iş çalar

- Preemption: Goroutine’ler 10ms’de bir preempt edilir (Go 1.14+)

- System Call Handling: System call yapan goroutine, M’den ayrılır ve yeni M oluşturulur

- Network Poller: I/O işlemleri için özel poller thread’i

- Spinning Threads: CPU’yu verimli kullanmak için spinning mekanizması

Preemption Mekanizması (Go 1.14+)

Go 1.14’ten önce, goroutine’ler sadece cooperative olarak preempt ediliyordu (runtime.Gosched(), channel operations, function calls). Bu, CPU yoğun goroutine’lerin diğerlerini aç bırakmasına neden olabiliyordu.

Async Preemption (Go 1.14+)

Preemption Tipleri:

-

Cooperative Preemption (Eski yöntem)

runtime.Gosched()çağrısı- Channel operations

- Function call boundaries

- Stack growth

-

Async Preemption (Go 1.14+)

- Sysmon goroutine: Her 10ms’de bir kontrol eder

- SIGURG signal: Preempt edilecek goroutine’e gönderilir

- Function prologue: Her fonksiyon başında preempt flag kontrol edilir

- Stack scanning: Preempt edilecek goroutine’in stack’i taranır

|

|

Preemption Timeline:

🔧 Production Notu:

Async preemption mekanizması özellikle yüksek CPU kullanan servislerde latency spike’larını önlemek için kritiktir. CPU-bound goroutine’lerin diğer goroutine’leri aç bırakmasını engelleyerek, production’da daha öngörülebilir performans sağlar.

Spinning Threads

Spinning, bir P’nin iş beklerken CPU’yu boş bırakmak yerine aktif olarak beklemesidir. Bu, yeni goroutine’ler geldiğinde hızlı tepki vermeyi sağlar.

Spinning Stratejisi:

- P, local queue boşken ~1ms spinning yapar

- Bu süre içinde yeni goroutine gelirse hemen çalıştırır

- Spinning süresi dolunca OS thread sleep’e gider

- Yeni goroutine geldiğinde thread uyandırılır

Spinning Avantajları:

- Düşük latency (yeni işler hemen çalışır)

- CPU verimliliği (idle thread’ler CPU’yu bloke etmez)

Spinning Dezavantajları:

- CPU kullanımı (spinning sırasında CPU çalışır)

- Güç tüketimi (laptop’larda önemli)

Network Poller Entegrasyonu

Network poller, I/O işlemlerini non-blocking yapmak için kullanılır. Go, epoll (Linux), kqueue (BSD), IOCP (Windows) gibi platform-specific API’leri kullanır.

Network Poller Yapısı:

|

|

Network Poller Thread:

- Tek bir dedicated OS thread

- epoll_wait() / kqueue() ile event’leri bekler

- I/O tamamlandığında ilgili goroutine’i uyandırır

System Call Wrapping

System call yapan goroutine’ler, P’yi serbest bırakmalıdır. Böylece başka goroutine’ler çalışabilir.

entersyscall/exitsyscall Mekanizması:

|

|

System Call Senaryoları:

-

Blocking System Call (read, write, accept)

- P serbest bırakılır

- Yeni M oluşturulabilir (eğer gerekiyorsa)

- System call tamamlanınca P bulunur

-

Non-Blocking System Call (hızlı işlemler)

- P tutulur (kısa süreli)

- System call hemen tamamlanır

- P’yi serbest bırakmaya gerek yok

M Oluşturma Stratejisi:

M Limit:

- Varsayılan: 10,000 M

runtime/debug.SetMaxThreads()ile ayarlanabilir- Çok fazla M, OS kaynaklarını tüketir

Work Stealing Detayları

Work stealing, boşta kalan P’lerin dolu P’lerden iş çalmasıdır.

Work Stealing Algoritması:

|

|

GOMAXPROCS

|

|

Varsayılan olarak CPU çekirdek sayısına eşittir. Artırırsanız:

- Daha fazla paralelizm

- Daha fazla context switch overhead

- Daha fazla bellek kullanımı

GOMAXPROCS Tuning:

|

|

🔧 Production Notu:

GOMAXPROCS değerini production’da workload tipine göre ayarlamak kritiktir. I/O-bound servislerde CPU sayısının 2-4 katı, CPU-bound servislerde ise CPU sayısı kadar ayarlanmalıdır. Yanlış ayar, context switch overhead’i veya CPU underutilization’a neden olabilir.

Pratik Örnek: Scheduler’ı Gözlemleme

|

|

Scheduler Trace Analizi

|

|

Trace Çıktısı Açıklaması:

gomaxprocs=4: 4 P aktifidleprocs=0: Boşta P yokthreads=5: 5 OS thread (4 M + 1 network poller)spinningthreads=0: Spinning thread yokidlethreads=0: Idle thread yokrunqueue=0: Global queue’da goroutine yok[0 0 0 0]: Her P’nin local queue’sundaki goroutine sayısı

6. Channel’lar ile İletişim

Go’da goroutine’ler genellikle shared memory yerine channel kullanarak haberleşir. Bu yaklaşım:

“Belleği paylaşarak iletişim kurma, iletişim kurarak belleği paylaş.”

felsefesine dayanır.

Channel Tipleri

Unbuffered Channel

|

|

Özellikler:

- Senkron iletişim (rendezvous)

- Gönderici ve alıcı aynı anda hazır olmalı

- Blocking operation

Buffered Channel

|

|

Özellikler:

- Asenkron iletişim

- Buffer dolana kadar non-blocking

- Buffer doluysa blocking

Channel İşlemleri

Select Statement

|

|

Select mekanizması:

Channel Kapanması

|

|

Kapalı channel özellikleri:

- Receive işlemi hemen zero value döner

- Send işlemi panic oluşturur

- Kapalı channel’a tekrar close() panic oluşturur

Channel Patterns

1. Worker Pool Pattern

|

|

2. Fan-Out / Fan-In Pattern

|

|

7. Bellek Yönetimi

Go’da bellek yönetimi otomatiktir, ancak stack ve heap arasındaki farkı anlamak performans için kritiktir.

Stack vs Heap

| Özellik | Stack | Heap |

|---|---|---|

| Allocation Hızı | Çok Hızlı (pointer aritmetiği) | Yavaş (GC ile) |

| Deallocation | Otomatik (fonksiyon bitince) | GC tarafından |

| Boyut | Küçük (MB seviyesi) | Büyük (GB seviyesi) |

| Erişim | LIFO | Rastgele |

| Thread Safety | Her goroutine’in kendi stack’i | Paylaşılan |

Escape Analysis

Go derleyicisi, bir değişkenin stack’te mi yoksa heap’te mi saklanacağına escape analysis ile karar verir.

Escape Analysis Örnekleri

Stack’te Kalır

|

|

🔧 Production Notu:

Escape analysis’ı anlamak production performansı için kritiktir.

go build -gcflags=-mkomutu ile hangi değişkenlerin heap’e kaçtığını görebilirsiniz. Stack’te kalan değişkenler GC overhead’i olmadan çalışır, bu da özellikle hot path’lerde önemli performans kazancı sağlar.

Heap’e Kaçar

|

|

Bellek Yapısı

Memory Layout Görselleştirmesi

Go programının bellek düzeni (Linux x86-64):

|

|

Memory Segment Detayları:

Memory Layout Özellikleri:

| Segment | Yön | Boyut | Özellik |

|---|---|---|---|

| Stack | Aşağı | 2KB-1GB | Per goroutine, guard pages |

| Heap | Yukarı | Dinamik | GC tarafından yönetilir |

| Data | - | Statik | Global variables, constants |

| Text | - | Statik | Executable code, read-only |

Guard Pages:

- Stack overflow’u tespit etmek için

- Stack’in sonunda özel sayfalar

- Erişim → segmentation fault

Stack Büyümesi ve Küçülmesi

Goroutine stack’i dinamik olarak büyür ve küçülür:

Stack büyüme mekanizması:

- Stack overflow riski tespit edilir (guard page’e yaklaşma)

- Yeni, daha büyük stack oluşturulur (2x büyüklükte)

- Eski stack’ten yeni stack’e kopyalama yapılır

- Pointer’lar güncellenir (stack copying GC ile)

- Eski stack serbest bırakılır

Stack shrinking mekanizması:

Stack Shrinking Koşulları:

- GC sırasında stack scanning yapılır

- Stack’in %50’den fazlası kullanılmıyorsa küçültülür

- Minimum stack boyutu: 2KB

- Stack shrinking, GC overhead’ini azaltır

Stack Splitting vs Stack Copying

Go, stack büyümesi için iki farklı yaklaşım denedi:

Stack Splitting (Go 1.2 ve Öncesi)

Nasıl Çalışırdı:

- Stack büyümesi gerektiğinde, yeni bir stack segment’i allocate edilirdi

- Eski stack’teki pointer’lar yeni stack’e işaret edecek şekilde güncellenirdi

- Stack, linked list gibi segment’lerden oluşurdu

Sorunlar:

- Hot split problem: Sık büyüyen stack’lerde performans sorunu

- Complex pointer updates: Tüm pointer’ları güncellemek zor

- Cache locality: Segment’ler farklı memory bölgelerinde

- GC complexity: Stack scanning daha karmaşık

Stack Copying (Go 1.3+)

Nasıl Çalışır:

- Yeni, daha büyük stack allocate edilir (2x)

- Eski stack’ten yeni stack’e tüm veri kopyalanır

- Pointer’lar güncellenir (stack copying GC ile)

- Eski stack serbest bırakılır

Avantajlar:

- Basitlik: Tek bir continuous memory region

- Performance: Daha iyi cache locality

- GC simplicity: Stack scanning daha basit

- Predictability: Daha öngörülebilir performans

Neden Copying Tercih Edildi:

Copying Overhead:

- Copy cost: ~1-5µs (stack size’a göre)

- Pointer update: GC tarafından otomatik

- Frequency: Nadir (stack büyümesi sık değil)

Copying Optimizasyonları:

- Copy-on-write: Mümkün olduğunda

- Bulk copy: Memory copy optimizasyonları

- GC integration: Stack copying GC ile entegre

Memory Allocator Mimarisi: mcache, mcentral, mheap

Go’nun memory allocator’ü üç katmanlı bir yapı kullanır:

mcache (Per-P Cache)

Her P’nin kendi mcache’i vardır. Lock-free allocation sağlar.

|

|

Özellikler:

- Lock-free: P’ye özel olduğu için lock gerekmez

- Hızlı allocation: Local cache’den direkt alır

- Refill: Cache boşalınca mcentral’dan doldurulur

mcentral (Global Pool)

Tüm P’ler tarafından paylaşılan merkezi pool.

|

|

Özellikler:

- Lock-protected: Concurrent access için lock kullanır

- Size class bazlı: Her size class için ayrı mcentral

- Span management: Partial ve full span’leri yönetir

mheap (OS Memory)

OS’ten bellek alan ve span’leri yöneten ana yapı.

|

|

Özellikler:

- Arena-based: Büyük bellek blokları (64MB arena)

- Span allocation: Span’leri arena’lardan ayırır

- OS interaction: mmap/munmap ile OS ile iletişim

Span Yapısı

Span, bellek yönetiminin temel birimidir. Bir veya daha fazla sayfa (page) içerir.

Span Özellikleri:

- Size: 8KB ile 512KB arası (sayfa sayısına göre)

- Size class: Span içindeki object boyutunu belirler

- State: Free, partial, full

- Link list: mcentral’da linked list ile yönetilir

Span Lifecycle:

Size Class Mekanizması

Go, 67 farklı size class kullanır:

|

|

Size Class Hesaplama:

Size Class Avantajları:

- Internal fragmentation azaltır: Benzer boyutlu object’ler aynı span’de

- Hızlı allocation: Free list’ten direkt alınır

- Cache efficiency: Locality artar

Memory Allocation Akışı

Large Object Allocation

32KB’den büyük object’ler doğrudan mheap’ten allocate edilir:

|

|

Large Object Özellikleri:

- Direct allocation: mcache/mcentral bypass

- Zero-copy: Büyük object’ler için optimize

- GC overhead: Büyük object’ler GC’yi etkiler

Memory Pool

Go, küçük objeler için memory pool kullanır:

Size class’lar:

- 8, 16, 32, 48, 64, 80, 96, 112, 128, 144, 160, … bytes

- Her size class için ayrı pool

- Hızlı allocation/deallocation

Memory Ordering ve Atomic Operations

Go, memory ordering için atomic operations sağlar:

|

|

Memory Ordering Semantics:

Go Atomic Operations:

- Load: Acquire semantics

- Store: Release semantics

- CAS: Acquire-Release semantics

- Add/Sub: Sequentially consistent

Kullanım Senaryoları:

- Lock-free data structures

- Counter’lar

- Flag’ler

- Memory allocator internal’ları

Pratik İpuçları

- Pointer’ları gereksiz kullanmayın: Stack’te kalması daha hızlı

- Büyük struct’ları pointer ile geçirin: Copy overhead’ini azaltır

- Escape analysis’ı kontrol edin:

go build -gcflags=-m - Memory profiling yapın:

go tool pprof

8. Garbage Collector (GC)

Go’nun Garbage Collector’ü, kullanılmayan bellek alanlarını otomatik olarak temizler. Modern, concurrent ve low-latency bir tasarıma sahiptir.

GC Tarihçesi

GC Algoritması: Tri-Color Mark & Sweep

GC Süreci

GC Fazları

1. Mark Phase (Concurrent)

|

|

Mark phase özellikleri:

- Concurrent: Uygulama çalışmaya devam eder

- Write Barrier: Mutator yazarken mark bilgisini korur

- Work-Stealing: Paralel marking için

2. Mark Termination (Stop-the-World)

STW süresi:

- Go 1.8+: < 1ms (çoğu durumda < 100µs)

- Go 1.12+: < 100µs (çoğu durumda)

- Go 1.18+: Daha da optimize edildi

3. Sweep Phase (Concurrent)

|

|

GC Trigger Mekanizması

GC şu durumlarda tetiklenir:

GOGC değişkeni:

- Varsayılan: 100

- Anlamı: Heap %100 büyüdüğünde GC tetiklenir

- Örnek: 50MB heap → 100MB olunca GC

|

|

🔧 Production Notu:

GOGC değerini production’da workload’a göre optimize etmek önemlidir. Yüksek throughput gerektiren servislerde GOGC=200-300, düşük latency gerektiren servislerde GOGC=50-100 değerleri genellikle daha uygun olur. Memory limit (Go 1.19+) ile birlikte kullanıldığında daha iyi kontrol sağlar.

Write Barrier Implementasyonu

Write barrier, GC sırasında mutator’ın (uygulama) yazdığı pointer’ları takip etmek için kullanılır.

Write Barrier Tipleri:

- Hybrid Write Barrier (Go 1.8+)

|

|

Write Barrier Overhead:

- Her pointer write’ında çağrılır

- ~5-10ns overhead per write

- Compiler tarafından optimize edilir (gerekli yerlerde)

GC Pacing Algoritması

Pacing, GC’nin ne zaman başlayacağını ve ne kadar hızlı çalışacağını belirler.

Pacing Hesaplaması:

|

|

Pacing Stratejisi:

- Heap büyüme hızına göre: Hızlı büyüme → Daha sık GC

- Allocation rate’e göre: Yüksek allocation → Daha fazla mark assist

- CPU budget’e göre: GC, CPU’nun %25’ini kullanabilir

GC Assists Mekanizması

GC assist, allocation yapan goroutine’lerin GC’ye yardım etmesidir.

GC Assist Hesaplama:

|

|

Assist Özellikleri:

- Proportional: Allocation miktarına göre

- Fair: Her goroutine eşit katkı sağlar

- Non-blocking: GC worker’ları bloklamaz

Scavenging (Memory Return to OS)

Scavenging, kullanılmayan bellek alanlarını OS’e geri verir.

Scavenging Stratejisi:

|

|

Scavenging Özellikleri:

- Lazy: İhtiyaç duyuldukça yapılır

- Threshold-based: Minimum free memory gerekir

- OS-specific: Linux’ta MADV_FREE, Windows’ta VirtualFree

Scavenging Timeline:

GC Phases Timeline

GC Phase Süreleri:

- Mark Phase: 5-50ms (heap size’a göre)

- Mark Termination: < 100µs (STW)

- Sweep Phase: 5-20ms (concurrent)

- Scavenge: 1-5ms (lazy)

GC Performans Metrikleri

|

|

GC Metrikleri:

NumGC: Toplam GC sayısıPauseTotalNs: Toplam pause süresiGCCPUFraction: GC için kullanılan CPU oranıNextGC: Bir sonraki GC trigger threshold’uHeapAlloc: Mevcut heap kullanımı

GC Optimizasyon İpuçları

- Object Pool Kullanın:

sync.Poolile tekrar kullanım - GOGC Ayarlayın: Uygulamanıza göre optimize edin

- Büyük Allokasyonlardan Kaçının: Küçük, sık allokasyonlar daha iyi

- Pointer’ları Azaltın: GC mark overhead’ini azaltır

- Memory Profiling:

go tool pprofile analiz yapın

sync.Pool Kullanımı

|

|

Pool avantajları:

- GC pressure’ı azaltır

- Allocation overhead’ini azaltır

- Memory reuse sağlar

🔧 Production Notu:

sync.Poolkullanımı özellikle yüksek throughput gerektiren servislerde kritiktir. Sık allocate edilen ve kısa ömürlü objeler için pool kullanmak GC pressure’ı önemli ölçüde azaltır. Ancak pool’dan alınan objelerin sıfırlanması gerektiğini unutmayın, aksi halde data leak riski vardır.

9. Go vs Diğer Diller

Go vs JavaScript

| Özellik | Go | JavaScript |

|---|---|---|

| Çalışma | Derlenen (AOT) | Yorumlanan (JIT) |

| Concurrency | Goroutine (M:N) | Event Loop (1:N) |

| Thread Model | Çoklu thread | Tek thread |

| Runtime | Go Runtime | V8/SpiderMonkey |

| Tip Sistemi | Statik | Dinamik |

| GC | Concurrent Mark-Sweep | Generational |

| Performans | Yüksek | Orta-Yüksek |

| Kullanım | Backend, Systems | Frontend, Backend |

Go vs Java

| Özellik | Go | Java |

|---|---|---|

| Derleme | Native binary | Bytecode (JVM) |

| Runtime | Go Runtime | JVM |

| GC | Concurrent, basit | Generational, kompleks |

| Concurrency | Goroutine (hafif) | Thread (ağır) |

| Tip Sistemi | Statik, basit | Statik, kompleks |

| Dependency | Tek binary | JAR dosyaları |

| Başlatma | Hızlı | Yavaş (JVM warmup) |

Go vs Rust

| Özellik | Go | Rust |

|---|---|---|

| Memory Safety | GC ile | Ownership ile |

| Concurrency | Goroutine | async/await |

| Performans | Yüksek | Çok Yüksek |

| Öğrenme Eğrisi | Kolay | Zor |

| GC | Var | Yok |

| Null Safety | Interface{} ile | Option |

10. Mutex ve Atomic Operations

Go’da concurrency için channel’ların yanı sıra, geleneksel synchronization primitives de mevcuttur.

sync.Mutex

Mutex, critical section’ları korumak için kullanılır.

|

|

Mutex Özellikleri:

- Exclusive lock: Bir goroutine lock alır, diğerleri bekler

- Reentrant değil: Aynı goroutine tekrar lock alamaz

- Fair değil: FIFO garantisi yok

sync.RWMutex

RWMutex, okuma ve yazma işlemlerini ayırır.

|

|

RWMutex Özellikleri:

- Multiple readers: Birden fazla goroutine aynı anda okuyabilir

- Single writer: Yazma sırasında tüm okuyucular bekler

- Write priority: Yazma istekleri okuma isteklerinden önceliklidir

Mutex vs RWMutex Performansı:

Atomic Operations

Atomic operations, lock-free programming için kullanılır.

|

|

Atomic vs Mutex:

| Özellik | Atomic | Mutex |

|---|---|---|

| Overhead | Düşük (~5ns) | Yüksek (~50ns) |

| Kullanım | Basit counter’lar | Kompleks data structures |

| Lock-free | Evet | Hayır |

| Deadlock riski | Yok | Var |

Atomic Kullanım Senaryoları:

- Counter’lar

- Flag’ler

- Pointer’lar

- Lock-free data structures

Mutex vs Channel Karşılaştırması

|

|

Ne Zaman Mutex, Ne Zaman Channel?

Kural:

- Mutex: Shared state koruması için

- Channel: Goroutine’ler arası iletişim için

- Atomic: Basit counter/flag için

11. Advanced Channel Patterns

Pipeline Pattern

Pipeline, veriyi bir dizi stage’den geçirir.

|

|

Pipeline Avantajları:

- Modüler yapı

- Paralel işleme

- Backpressure handling

Cancellation Pattern

Context ile cancellation pattern’i:

|

|

Error Handling Pattern

Error channel pattern:

|

|

Timeout Pattern

|

|

12. Anti-Patterns ve Common Mistakes

❌ Goroutine Leak Örnekleri

Leak 1: Unbuffered Channel

|

|

Çözüm:

|

|

Leak 2: Range Loop Variable Capture

|

|

Çözüm:

|

|

Leak 3: Defer in Goroutine

|

|

Çözüm:

|

|

❌ Deadlock Senaryoları

Deadlock 1: Mutual Blocking

|

|

Deadlock 2: Lock Ordering

|

|

Çözüm: Lock ordering

|

|

❌ Context Propagation Hataları

|

|

✅ Doğru Yaklaşımlar

- Channel’ları mutlaka kapatın

- Context’i tüm alt işlemlere geçirin

- WaitGroup kullanın goroutine’lerin bitmesini beklemek için

- Select ile timeout ekleyin

- Race detector kullanın:

go run -race

🔧 Production Notu:

Goroutine leak’leri ve deadlock’lar production’da en yaygın sorunlardandır. Tüm channel’ları kapatmak, context propagation yapmak ve timeout’lar eklemek kritiktir. Race detector’ı CI/CD pipeline’ınıza ekleyin, ancak production’da çalıştırmayın çünkü ~10x performans overhead’i vardır.

13. Pratik Örnekler ve Best Practices

Örnek 1: Worker Pool Pattern

|

|

Örnek 2: Rate Limiting

|

|

Örnek 3: Context ile Timeout

|

|

Best Practices

- Channel’ları Kapatmayı Unutmayın: Producer channel’ı kapatmalı

- Context Kullanın: Timeout ve cancellation için

- sync.Pool Kullanın: Sık allokasyon edilen objeler için

- Goroutine Leak’lerinden Kaçının: Channel’ları mutlaka kapatın

- Race Condition Kontrolü:

go run -raceile test edin - Memory Profiling: Production’da memory kullanımını izleyin

- GC Tuning: GOGC değişkenini uygulamanıza göre ayarlayın

14. Debugging ve Profiling (Genişletilmiş)

Race Detector

|

|

Race condition’ları tespit eder, ancak performans overhead’i vardır (~10x slowdown).

Race Detector Özellikleri:

- Tüm goroutine’leri izler

- Memory access’leri loglar

- Race condition’ları raporlar

- Sadece development’ta kullanılmalı

Memory Profiling

|

|

|

|

Memory Profiling Metrikleri:

alloc_space: Toplam allocationalloc_objects: Toplam object sayısıinuse_space: Mevcut kullanıminuse_objects: Mevcut object sayısı

🔧 Production Notu:

Production’da profiling yaparken

net/http/pprofkullanarak runtime’da profil toplayabilirsiniz. Ancak CPU profiling’in overhead’i olduğunu unutmayın. Profil toplama süresini kısa tutun (10-30 saniye) ve sadece gerektiğinde aktif edin. Memory profiling daha az overhead’li olduğu için daha sık kullanılabilir.

CPU Profiling

|

|

CPU Profiling Kullanımı:

|

|

Goroutine Profiling

|

|

Goroutine Profiling:

- Aktif goroutine sayısı

- Goroutine stack trace’leri

- Blocking goroutine’ler

Trace Analysis

|

|

|

|

Trace Analizi:

- Goroutine timeline

- GC events

- Network I/O

- System calls

- Scheduler events

Memory Leak Detection

|

|

GOMAXPROCS Tuning Stratejileri

|

|

GOMAXPROCS Benchmark:

|

|

CPU Profiling Interpretation

Flame Graph Okuma:

- Genişlik: CPU kullanımı

- Yükseklik: Call stack derinliği

- Renk: Rastgele (farklı fonksiyonlar)

Optimizasyon Hedefleri:

- En geniş fonksiyonlar

- Sık çağrılan fonksiyonlar

- Hot path’ler

Troubleshooting Checklist

|

|

Performance Tuning Guide

-

Baseline Ölçümü

- CPU kullanımı

- Memory kullanımı

- Latency

- Throughput

-

Profil Alma

- CPU profiling

- Memory profiling

- Trace analysis

-

Optimizasyon

- Hot path’leri optimize et

- Memory allocation’ları azalt

- GC pressure’ı azalt

-

Doğrulama

- Benchmark çalıştır

- Profil tekrar al

- Karşılaştır

15. Production Insights

Graceful Shutdown

|

|

Circuit Breaker Pattern

|

|

Retry Logic

|

|

Telemetry & Observability

|

|

16. Reflection ve Interface

Interface Internal Representation

Go’da interface’ler iki tiptir:

- iface: Method’lu interface’ler

- eface: Empty interface (interface{})

Interface Memory Layout:

|

|

Type Assertion Maliyeti

|

|

Type Assertion Overhead:

- Direct assertion: ~1-2ns

- Type switch: ~2-5ns

- Reflection: ~50-100ns

Interface Method Dispatch

Interface method çağrıları, virtual table lookup kullanır:

|

|

Method Dispatch Mekanizması:

itab (Interface Table) Yapısı:

|

|

Method Dispatch Overhead:

- Direct call: ~1ns (concrete type)

- Interface call: ~2-5ns (virtual table lookup)

- Indirect call overhead: ~1-3ns

Dispatch Optimizasyonları:

- Devirtualization: Compiler bazen direct call’a optimize eder

- Inlining: Küçük method’lar inline edilebilir

- Type specialization: Generic’ler (Go 1.18+) daha hızlı

Reflection Overhead

|

|

Reflection Kullanım Senaryoları:

- JSON/XML marshaling

- ORM frameworks

- Configuration parsing

- Testing frameworks

Reflection Overhead:

- ValueOf: ~50ns

- TypeOf: ~10ns

- Method call: ~100ns

17. Performance Benchmarks

Channel vs Mutex Benchmark

|

|

Gerçek Benchmark Sonuçları:

|

|

Sonuçlar:

- Channel: ~35ns per operation

- Mutex: ~18ns per operation

- Atomic: ~2ns per operation

Goroutine vs Thread Creation Benchmark

|

|

Gerçek Benchmark Sonuçları:

|

|

Sonuçlar:

- Goroutine creation: ~300ns

- OS Thread creation: ~250,000ns (833x daha yavaş!)

Stack vs Heap Allocation Benchmark

|

|

Sonuçlar:

- Stack: ~0.5ns per allocation

- Heap: ~50ns per allocation

Buffered vs Unbuffered Channel

|

|

Sonuçlar:

- Buffered: ~30ns per operation

- Unbuffered: ~200ns per operation (goroutine overhead)

Go Versiyon Karşılaştırması

| Özellik | Go 1.18 | Go 1.19 | Go 1.20 | Go 1.21 | Go 1.22 |

|---|---|---|---|---|---|

| GC Pause | ~100µs | ~80µs | ~60µs | ~50µs | ~40µs |

| Generics | ✅ | ✅ | ✅ | ✅ | ✅ |

| Fuzzing | ✅ | ✅ | ✅ | ✅ | ✅ |

| PGO | ❌ | ❌ | Preview | ✅ | ✅ |

| Memory Limit | ❌ | ✅ | ✅ | ✅ | ✅ |

| Range Func | ❌ | ❌ | ❌ | Preview | ✅ |

| Async Preemption | ✅ | ✅ | ✅ | ✅ | ✅ |

PGO (Profile-Guided Optimization):

- Go 1.20: Preview

- Go 1.21+: Production ready

- Compile-time optimization based on runtime profiles

- %5-15 performans artışı

Memory Limit (Go 1.19+):

|

|

- GC’yi daha agresif tetikler

- Memory kullanımını sınırlar

18. İleri Seviye Konular

Assembly Optimizations

Go compiler, assembly seviyesinde optimizasyonlar yapar:

|

|

Compiler Optimizations:

- Inlining

- Dead code elimination

- Constant propagation

- Loop unrolling

- Register allocation

cgo Overhead

cgo, C kodu ile entegrasyon sağlar, ancak overhead’i vardır:

|

|

cgo Overhead:

- Function call: ~100ns

- Context switch: Go ↔ C

- Memory management: C heap

Plugin System

Go plugins, runtime’da dinamik yükleme sağlar:

|

|

Plugin Özellikleri:

- Runtime loading

- Symbol resolution

- Isolation

Build Tags ve Conditional Compilation

|

|

Build Tags Kullanımı:

- Platform-specific code

- Feature flags

- Testing

19. Gerçek Dünya Case Studies

Case Study 1: High-Traffic API Optimizasyonu

Problem:

- 100K req/s API endpoint

- Yüksek latency (200ms p95)

- Yüksek memory kullanımı (4GB)

- GC pause’ları (50ms)

Analiz:

|

|

Tespit Edilen Sorunlar:

- Goroutine leak: 10,000+ goroutine (channel’lar kapatılmamış)

- Excessive heap allocation: Her request’te büyük struct’lar

- GC pressure: Çok fazla küçük allocation

- GOMAXPROCS: Varsayılan değer (CPU sayısı)

Çözümler:

|

|

Sonuçlar:

- Latency: 200ms → 50ms (4x iyileşme)

- Memory: 4GB → 1GB (4x azalma)

- Throughput: 100K → 300K req/s (3x artış)

- GC Pause: 50ms → 10ms (5x iyileşme)

Case Study 2: Docker’ın Go Kullanımı

Neden Go Seçildi?

- Native binary: Dağıtım kolaylığı

- Cross-platform: Linux, Windows, macOS

- Concurrency: Container management için ideal

- Performance: C’ye yakın performans

Yapılan Optimizasyonlar:

- Memory pooling: Container metadata için

- Goroutine management: Container lifecycle için

- GC tuning: Production workload’a göre

- cgo minimization: C dependency’leri azaltıldı

Karşılaşılan Sorunlar:

- cgo overhead: C library’ler ile entegrasyon

- GC latency: Container start/stop sırasında

- Memory leaks: Container cleanup’da

Çözümler:

- cgo wrapper: Minimal cgo kullanımı

- GC tuning: GOGC=200

- Resource cleanup: Defer pattern’leri

Case Study 3: Kubernetes Scheduler

Scheduler Performansı:

- Pod scheduling: < 1ms latency

- Concurrent scheduling: 1000+ pods/s

- Memory efficiency: < 100MB heap

Memory Optimizasyonları:

- sync.Pool: Pod object’leri için

- Object reuse: Allocation overhead’i azaltma

- GC tuning: Low-latency için optimize

GC Tuning Stratejileri:

|

|

Scheduler Optimizasyonları:

- Work queue: Priority queue implementation

- Goroutine pool: Scheduler worker’ları

- Batch processing: Pod scheduling

🔧 Production Notu:

Kubernetes gibi production sistemlerde Go’nun scheduler’ı kritik öneme sahiptir. Scheduler’ın performansını optimize etmek için goroutine pool’ları, work queue’lar ve batch processing kullanılır. Bu pattern’ler yüksek throughput ve düşük latency gerektiren production sistemlerinde standart yaklaşımdır.

20. Production Debugging Senaryoları

Senaryo 1: Yüksek Memory Kullanımı

Semptomlar:

- Memory kullanımı sürekli artıyor

- GC sık çalışıyor

- Application yavaşlıyor

Debug Adımları:

|

|

Çözüm Örnekleri:

sync.Poolkullanımı- Memory leak’leri düzeltme

- Büyük allocation’ları azaltma

Senaryo 2: Yüksek CPU Kullanımı

Semptomlar:

- CPU %100 kullanımı

- Yüksek latency

- Throughput düşüşü

Debug Adımları:

|

|

Flame Graph Yorumlama:

- Genişlik: CPU kullanım oranı

- Yükseklik: Call stack derinliği

- Renk: Farklı fonksiyonlar

Çözüm Örnekleri:

- Hot path optimizasyonu

- Algorithm iyileştirmeleri

- Inefficient loop’ları optimize etme

Senaryo 3: Goroutine Leak

Semptomlar:

- Goroutine sayısı sürekli artıyor

- Memory kullanımı artıyor

- Application yavaşlıyor

Debug Adımları:

|

|

Tespit:

|

|

Çözüm:

- Channel’ları kapatma

- Context cancellation

- Timeout ekleme

Senaryo 4: Deadlock

Semptomlar:

- Application donuyor

- Hiçbir response yok

- CPU kullanımı düşük

Debug Adımları:

|

|

Deadlock Tespiti:

- Tüm goroutine’ler bloklanmış

- Mutex’ler veya channel’lar bekliyor

- Circular dependency

Çözüm:

- Lock ordering düzeltme

- Timeout ekleme

- Context cancellation

21. Advanced Optimization Techniques

Memory Arena Pattern

Custom allocator ile GC bypass:

|

|

Kullanım Senaryoları:

- Geçici object’ler için

- Batch processing

- GC pressure’ı azaltma

Zero-Copy Techniques

|

|

Dikkat:

unsafepackage kullanımı- Memory safety riski

- Sadece gerekli durumlarda

Inline Assembly

|

|

Kullanım:

- Critical path optimizasyonları

- Platform-specific optimizations

- Performance-critical code

PGO (Profile-Guided Optimization) - Go 1.21+

|

|

Avantajlar:

- %5-15 performans artışı

- Hot path optimizasyonları

- Better inlining decisions

🔧 Production Notu:

PGO (Profile-Guided Optimization) Go 1.21+ ile production-ready hale geldi. Production workload’larınızdan profil toplayıp bu profil ile yeniden derleme yaparak %5-15 arası performans artışı elde edebilirsiniz. Özellikle hot path’lerde belirgin iyileştirmeler görülür. CI/CD pipeline’ınıza PGO build adımı eklemeyi düşünün.

22. Monitoring & Alerting

Metrics Collection

|

|

Key Metrics

Runtime Metrics:

go_goroutines: Goroutine sayısıgo_memstats_alloc_bytes: Heap allocationgo_memstats_gc_duration_seconds: GC süresigo_memstats_gc_cpu_fraction: GC CPU kullanımı

🔧 Production Notu:

Production’da monitoring ve alerting kritiktir. Goroutine sayısı, memory kullanımı ve GC pause süreleri için alert’ler kurun. Prometheus ve Grafana ile dashboard’lar oluşturun. Özellikle goroutine leak’leri ve memory leak’leri erken tespit etmek için sürekli monitoring yapın. Alert threshold’larını workload’unuza göre ayarlayın.

Application Metrics:

- Request latency (p50, p95, p99)

- Throughput (req/s)

- Error rate

- Memory usage

Alerting Rules

|

|

Observability Stack

23. Go Performance Cheat Sheet

Quick Reference

| İşlem | Süre | Kullanım |

|---|---|---|

| Goroutine creation | ~300ns | Concurrency |

| Channel send | ~35ns | Communication |

| Mutex lock | ~18ns | State protection |

| Atomic add | ~2ns | Simple counters |

| Stack alloc | ~0.5ns | Local variables |

| Heap alloc | ~80ns | Dynamic memory |

| Interface call | ~2-5ns | Polymorphism |

| Direct call | ~1ns | Concrete types |

| Reflection call | ~100ns | Dynamic dispatch |

When to Use What?

Channels:

- ✅ Goroutine’ler arası iletişim

- ✅ Event signaling

- ✅ Pipeline patterns

- ❌ Shared state protection

Mutex:

- ✅ Shared state protection

- ✅ Critical sections

- ❌ Goroutine communication

Atomic:

- ✅ Simple counters

- ✅ Flags

- ✅ Lock-free structures

- ❌ Complex operations

Stack vs Heap:

- ✅ Stack: Local variables, small objects

- ✅ Heap: Escaped variables, large objects

- ❌ Stack: Pointer return, closures

Performance Tips

-

Allocation Optimization:

- Stack allocation tercih et

sync.Poolkullan- Büyük allocation’ları azalt

-

GC Optimization:

GOGCayarla- Memory limit kullan (Go 1.19+)

- Pointer’ları azalt

-

Concurrency:

- Goroutine pool kullan

- Channel buffer size optimize et

- Context cancellation kullan

-

Compiler Optimizations:

- PGO kullan (Go 1.21+)

- Inlining için küçük fonksiyonlar

- Dead code elimination

Common Pitfalls Checklist

|

|

24. Özet ve Sonuç

Go’nun çalışma modeli şu temel prensiplere dayanır:

Go’nun Güçlü Yönleri

- Basitlik: Minimal syntax, öğrenmesi kolay

- Performans: Native binary, düşük latency

- Concurrency: Goroutine modeli ile kolay paralel programlama

- Tooling: Mükemmel araç seti (fmt, vet, pprof)

- Deployment: Tek binary, kolay dağıtım

- GC: Modern, concurrent, low-latency garbage collection

Kullanım Alanları

- Microservices: Yüksek throughput API’ler

- CLI Tools: Hızlı, native araçlar

- System Programming: Sistem seviyesi programlama

- Network Services: Yüksek performanslı network uygulamaları

- DevOps Tools: Docker, Kubernetes, Terraform gibi araçlar

- Cloud Services: Distributed systems

Sonuç

Go, performans + sadelik + concurrency dengesini çok iyi kuran bir dildir. Modern yazılım geliştirme ihtiyaçlarını karşılamak için tasarlanmış, pratik ve verimli bir araçtır. Bu yüzden microservice’ler, API’ler, CLI araçları ve sistem programlama için sıkça tercih edilir.

Go’nun çalışma modelini anlamak, daha verimli ve performanslı uygulamalar yazmanıza yardımcı olacaktır. Runtime mekanizmalarını bilmek, debugging ve optimization süreçlerinde de büyük avantaj sağlar.

25. Kaynaklar ve Referanslar

Go Source Code

- Go Runtime Source: https://github.com/golang/go/tree/master/src/runtime

- Go Compiler Source: https://github.com/golang/go/tree/master/src/cmd/compile

- Go Scheduler:

runtime/proc.go - Memory Allocator:

runtime/malloc.go,runtime/mheap.go - Garbage Collector:

runtime/mgc.go

Resmi Dokümantasyon

- Go Official Documentation: https://go.dev/doc/

- Go Blog: https://go.dev/blog/

- Go Specification: https://go.dev/ref/spec

- Effective Go: https://go.dev/doc/effective_go

Önemli Blog Yazıları

-

Russ Cox Blog: https://research.swtch.com/

- “Go Data Structures” serisi

- “Go Scheduler” yazıları

- “Go GC” detayları

-

Go Team Blog Yazıları:

- “Go GC: Prioritizing low latency and simplicity”

- “Go Scheduler: M, P, G”

- “Go 1.5 GC improvements”

Go Proposal Dökümanları

- Go Proposals: https://github.com/golang/proposal

- GC Proposals: GC iyileştirme önerileri

- Scheduler Proposals: Preemption, work-stealing iyileştirmeleri

Community Best Practices

- Go Code Review Comments: https://github.com/golang/go/wiki/CodeReviewComments

- Go Best Practices: https://github.com/golang/go/wiki/CodeReviewComments

- Go Performance Tips: https://github.com/golang/go/wiki/Performance

İlham Kaynakları

- “How Go Works” - Go runtime deep dives

- “Go Internals” - Runtime mekanizmaları

Önerilen Okumalar

- “The Go Programming Language” - Alan Donovan, Brian Kernighan

- “Concurrency in Go” - Katherine Cox-Buday

- Go Blog yazıları - Runtime, GC, Scheduler

- Go source code - Runtime implementasyonları

Not: Bu makale, Go runtime’ın derinlemesine bir incelemesidir. Production uygulamalarında bu bilgileri kullanırken, Go’nun resmi dokümantasyonunu ve best practice’leri de göz önünde bulundurmanız önerilir.